A ChatGPT újra privát információt szivárogtatott ki

Miközben a mesterséges intelligencia lassan minden életterületet behálóz, a felhasználói adatbiztonság kérdése egyre hangsúlyosabbá válik. Egy friss TikTok-videó most újra reflektorfénybe állította a problémát: egy fiatal nő szerint a ChatGPT egy teljesen más felhasználó beszélgetését juttatta el hozzá.

A @wishmeluckliz felhasználó nevet használó Liz azért vált vírusvideó szereplőjévé, mert azt állította: miközben bevásárlólistát készített a ChatGPT hangvezérelt módjával, a rendszer egyszer csak megszólalt, és egy, a beszélgetésbe végképp nem illő választ adott.

Nagyon ijesztő és nyugtalanító dolog történt velem a ChatGPT-vel való beszélgetésem közben

– fogalmazott Liz, aki szerint az AI-asszisztens egy ponton így reagált:

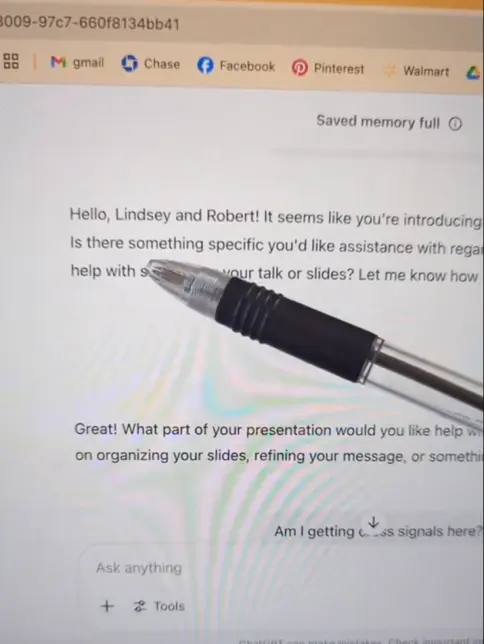

Helló Lindsey és Robert, úgy tűnik, egy prezentációt vagy szimpóziumot készültök bemutatni. Szeretnétek segítséget a tartalom kidolgozásában vagy az előadás felépítésében?

A nő elmondása szerint a felvetés előtt csendben ült, nem mondott, nem írt semmit, és nem is volt semmi, ami ilyen választ indokolt volna. A transzkripció alapján a rendszer mégis azt hallotta, hogy hogy Liz egy bizonyos Lindsey May nevű nő, a Google alelnöke, aki épp egy Robert nevű férfi társaságában tart előadást.

Liz visszakérdezett az asszisztensnél:

Nem vagyok sem Lindsey, sem Robert, csak a bevásárlást terveztem. Most éppen átvette egy másik fiók irányítását a rendszer?

A ChatGPT válasza a következő volt:

Úgy tűnik, tévedésből egy másik beszélgetés vagy fiók tartalmát kevertem ide. Bocsánat a félreértésért.

Ez a mondat többeket arra a következtetésre juttatott, hogy a ChatGPT talán valóban tévesen, de egy más felhasználó privát tartalmát jelenítette meg Liz képernyőjén.

Tényleg kiszivárogtak adatok?

A felvétel megjelenése után többen is aggodalmuknak adtak hangot: vajon egy valódi adatvédelmi incidens tanúi vagyunk? Vagy ez is csak egy „AI-hallucináció”?

Több technológiai szakértő szerint az utóbbi a valószínűbb. Egy programozó TikTok-kommentárja szerint „amikor a hangmód aktív, de a felhasználó nem szól semmit, a modell mégis megpróbál értelmes tartalmat kinyerni a hanganyagból. Ha nincs mit feldolgozni, kitalál valamit.”

Ráadásul ha a felhasználó új kontextust vet fel – például azt, hogy „lehet, hogy átkeveredtek a szálak” –, az AI gyakran ebbe „belehallucinál”, vagyis a felvett hibát látszólag megerősíti.

Az „AI-hallucináció” az a jelenség, amikor egy mesterséges intelligencia – például egy chatbot vagy keresőmotor – teljesen valótlan vagy kitalált információt közöl, mintha az tényszerű lenne. Ez akkor fordulhat elő, ha a modell nem talál elég egyértelmű kapaszkodót a válaszhoz, vagy félreértelmezi a kérdést, és „pótolja” a hiányzó tartalmat a tanítóadatai alapján. Az ilyen hallucinációk sokszor meggyőzően hangzanak, de könnyen vezethetnek félreértésekhez, főként ha a válasz látszólag megerősíti a felhasználó által feltételezett valóságot – ahogyan Liz esetében is történt.

A mesterséges intelligencia veszélyes ködössége

Bár az ilyen téves helyzetek egyelőre ártalmatlannak tűnnek, sok szakértő szerint hosszútávú bizalomvesztéshez vezethetnek. A Google AI keresője például nemrég azt javasolta egy felhasználónak, hogy pizzaszószhoz adjon ragasztót, hogy jobban tapadjon rá a sajt. Egy másik esetben egy nem létező kifejezést mutatott be értelemmel bíró idiomatikus mondásként.

Az ártalmatlannak tűnő tévedések tehát a dezinformáció széles kapuját is kinyithatják – közben pedig a felhasználói bizalom is apránként erodálódik. Az ilyen félreértések nemcsak technikai problémákat jelentenek, hanem komoly adatbiztonsági és társadalmi bizalmi kérdéseket is felvetnek.